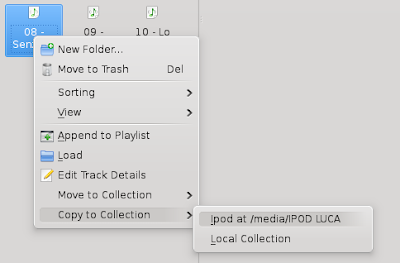

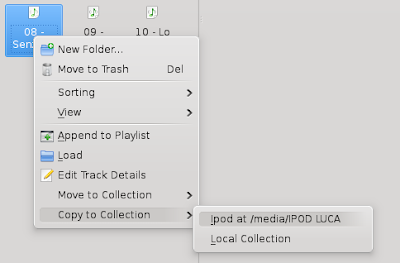

La prima installazione di OpenSolaris 2009.11 sul mio portatile mi ha portato ad una situazione dove solo la scheda di rete Wireless era funzionante, mentre quella wired (Atheros AR8121) risultata dispersa. Nemmeno l'utility dei driver era in grado di fornirmi il driver per la suddetta scheda. Dopo qualche ricerca ho trovato che il pacchetto che fornire i driver per la mia scheda è SUNWatge, dove ovviamente at sta per Atheros mentre ge per gigabit ethernet. Il problema è che OpenSolairs 2009.11 è al ramo di sviluppo snv 111, mentre il pacchetto di cui sopra richiede il 130.

E' stato quindi necessario installare l'aggiornamento dal repository di sviluppo di OpenSolaris, facendo avanzare il sistema fino a snv 130, per poi poter installare il driver della scheda di rete. Per fare questo ho anzitutto aggiunto il repository di sviluppo, l'ho impostato come repository di default, ed ho ordinato un image-update del sistema.

lunedì 28 dicembre 2009

mercoledì 16 dicembre 2009

Un ComboBox per selezionare le viste di una applicazione RCP

In una applicazione RCP che sto sviluppando mi è capitato di avere molte viste, ciascuna che deve essere associabile ad una serie di permessi. Per permettere ad un utente amministratore di selezionare a quali viste concedere quali permessi, ho creato un semplice wrapper attorno ad un combo che contiene l'array delle viste disponibili e la loro descrizione. Il codice è abbastanza banale, ma potrebbe tornare utile in altre applicazioni.

public class ViewsCombo {

/**

* The combo that will be displayed.

*/

private Combo combo = null;

/**

* The available views in the system.

*/

private IViewDescriptor[] availableViews = null;

/**

* Initializes the combo and the map to contain the views.

* @param parent

*/

public ViewsCombo( Composite parent, String viewIDToSelect ){

super();

// create the combo

this.combo = new Combo( parent, SWT.READ_ONLY );

// fill the combo with the data

this.fillComboAndMap();

// select a view if specified

if( viewIDToSelect != null )

for( int i = 0; i < availableviews =" (IViewDescriptor[])">

public class ViewsCombo {

/**

* The combo that will be displayed.

*/

private Combo combo = null;

/**

* The available views in the system.

*/

private IViewDescriptor[] availableViews = null;

/**

* Initializes the combo and the map to contain the views.

* @param parent

*/

public ViewsCombo( Composite parent, String viewIDToSelect ){

super();

// create the combo

this.combo = new Combo( parent, SWT.READ_ONLY );

// fill the combo with the data

this.fillComboAndMap();

// select a view if specified

if( viewIDToSelect != null )

for( int i = 0; i < availableviews =" (IViewDescriptor[])">

Database Independent

La nostra soluzione è indipendente dal database, quindi possiamo usarla con qualunque DBMS preferiate.

Quante volte ho sentito questa frase pronunciata da un qualche vendor di soluzioni informatiche!

Quello che si nasconde dietro questa frase è l'illusione della portabilità, ovvero il poter riusare la soluzione informatica in contesti disparati e con DBMS differenti.

Certo, la portabilità è buona, ma va saputa usare nel modo piu' opportuno, e farsi vanto di essere indipendenti dal database non sempre è una buona cosa, anzi per me è un errore grosso e anche grossolano.

E' un errore grosso perché generalmente al cliente finale non interessa l'interoperabilità del sistema proposto con altri DBMS. Lo scopo del cliente è quello di avere una soluzione informatica funzionante e performante (quest'ultimo punto è spesso molto importante), mentre l'indipendenza dal database è un fattore di interesse generalmente per gli sviluppatori. E' pur vero che il cliente potrebbe avere già un suo DBMS installato (o preferito) sul quale vuole far girare la applicazione in questione, e quindi avere un modo per "convertire" l'applicazione ad un altro DBMS è una buona cosa. Ma la parola chiave, spesso ignorata, è appunto "conversione": un conto è avere una soluzione informatica portabile, ovvero convertibile facilmente ad un'altra architettura (ossia ad un altro DBMS) e un conto è avere un sistema che è svincolato dal tipo di DBMS e quindi è già pronta per qualunque architettura. Quest'ultima soluzione, a mio avviso, è la peggiore. I piu' staranno saltando sulla sedia vista questa mia affermazione. Per meglio capire il mio pensiero occorre valutare anche la seconda parte dell'errore circa l'indipendenza dal database: la grossolanità.

Reputo l'indipendenza dal database un errore grossolano poiché automaticamente significa escludere tutte le funzioni evolute che il DBMS puo' offrire, e che nella maggior parte dei casi sono vendor-specific. Il rifiuto di ogni cosa non assomiglia ad una query standard porta a due problemi principali:

Quello che si nasconde dietro questa frase è l'illusione della portabilità, ovvero il poter riusare la soluzione informatica in contesti disparati e con DBMS differenti.

Certo, la portabilità è buona, ma va saputa usare nel modo piu' opportuno, e farsi vanto di essere indipendenti dal database non sempre è una buona cosa, anzi per me è un errore grosso e anche grossolano.

E' un errore grosso perché generalmente al cliente finale non interessa l'interoperabilità del sistema proposto con altri DBMS. Lo scopo del cliente è quello di avere una soluzione informatica funzionante e performante (quest'ultimo punto è spesso molto importante), mentre l'indipendenza dal database è un fattore di interesse generalmente per gli sviluppatori. E' pur vero che il cliente potrebbe avere già un suo DBMS installato (o preferito) sul quale vuole far girare la applicazione in questione, e quindi avere un modo per "convertire" l'applicazione ad un altro DBMS è una buona cosa. Ma la parola chiave, spesso ignorata, è appunto "conversione": un conto è avere una soluzione informatica portabile, ovvero convertibile facilmente ad un'altra architettura (ossia ad un altro DBMS) e un conto è avere un sistema che è svincolato dal tipo di DBMS e quindi è già pronta per qualunque architettura. Quest'ultima soluzione, a mio avviso, è la peggiore. I piu' staranno saltando sulla sedia vista questa mia affermazione. Per meglio capire il mio pensiero occorre valutare anche la seconda parte dell'errore circa l'indipendenza dal database: la grossolanità.

Reputo l'indipendenza dal database un errore grossolano poiché automaticamente significa escludere tutte le funzioni evolute che il DBMS puo' offrire, e che nella maggior parte dei casi sono vendor-specific. Il rifiuto di ogni cosa non assomiglia ad una query standard porta a due problemi principali:

- si reinventa la ruota;

- non si sfrutta al massimo il DBMS.

Il primo problema è facile da capire: il DBMS ha come solo scopo la gestione dei dati, e lo fa al meglio delle proprie capacità. Se non ci si fida del DBMS e si vuole riprogettare tutto quello che potrebbe essere fatto con estensioni del DBMS stesso (ad esempio query complesse via stored procedure) allora si sta scrivendo codice per replicare le funzionalità del DBMS. Questo risulta in uno spreco di risorse, tempo e generalmente in performance cattive. Unitamente a questo si ha che non si sfrutta il database al 100%, e considerando che spesso ci si trova a pagare licenze (dal costo elevato) per il solo utilizzo del DBMS, ciò corrisponde ad una perdita economica non sempre trascurabile. In altre parole, spesso il cliente si trova a pagare un costo di licenza per uno strumento, il DBMS, che viene usato solo in parte, e paga contemporaneamente i costi della realizzazione del software che implementa quelle funzionalità che non vengono sfruttate nel DBMS stesso!

A questo punto, dovrebbe iniziare ad essere chiaro che l'indipendenza dal database non sempre è una buona cosa, almeno per il fatto che implica costi aggiuntivi sul cliente (e sul fornitore prima).

Quindi non si deve progettare il sistema in modo che sia portabile? Ovviamente no, occorre fare una scelta implementativa mirata (ovvero stabilire quale DBMS puo' fornire il miglior rapporto qualità/prezzo per il sistema) e fornire implementazioni di supporto per i DBMS che non offrono le funzionalità richieste. In sostanza, occorre legarsi ad un DBMS e cercare di fornire supporto per gli altri, ma occorre che lo sviluppo sia orientato ad un DBMS specifico! Dopotutto scelte del genere nel processo di sviluppo sono già state fatte: la scelta del linguaggio, la scelta dell'IDE, la scelta del framework MVC, ecc., allora perché il database non dovrebbe sottostare a scelte analoghe?

L'indipendenza da un componente importante come il DBMS è per me utopia; è come se si comprasse un paio di scarpe ma non si usassero i lacci, perché dopotutto non tutte le scarpe hanno i lacci e quindi non si vogliono prendere abitudini non portabili. Ma così non si riuscirà mai a correre bene! E lo stesso avviene con i DBMS, che se non vengono sfruttati non possono fornire prestazioni elevate.

Quindi occorre fare una scelta, spesso coraggiosa: legarsi ad un DBMS che offra le migliori feature per il progetto che si sta facendo. E se il database è libero, allora questa scelta non imporrà costi addizionali sul cliente e potrà essere accettata facilmente.

A questo punto, dovrebbe iniziare ad essere chiaro che l'indipendenza dal database non sempre è una buona cosa, almeno per il fatto che implica costi aggiuntivi sul cliente (e sul fornitore prima).

Quindi non si deve progettare il sistema in modo che sia portabile? Ovviamente no, occorre fare una scelta implementativa mirata (ovvero stabilire quale DBMS puo' fornire il miglior rapporto qualità/prezzo per il sistema) e fornire implementazioni di supporto per i DBMS che non offrono le funzionalità richieste. In sostanza, occorre legarsi ad un DBMS e cercare di fornire supporto per gli altri, ma occorre che lo sviluppo sia orientato ad un DBMS specifico! Dopotutto scelte del genere nel processo di sviluppo sono già state fatte: la scelta del linguaggio, la scelta dell'IDE, la scelta del framework MVC, ecc., allora perché il database non dovrebbe sottostare a scelte analoghe?

L'indipendenza da un componente importante come il DBMS è per me utopia; è come se si comprasse un paio di scarpe ma non si usassero i lacci, perché dopotutto non tutte le scarpe hanno i lacci e quindi non si vogliono prendere abitudini non portabili. Ma così non si riuscirà mai a correre bene! E lo stesso avviene con i DBMS, che se non vengono sfruttati non possono fornire prestazioni elevate.

Quindi occorre fare una scelta, spesso coraggiosa: legarsi ad un DBMS che offra le migliori feature per il progetto che si sta facendo. E se il database è libero, allora questa scelta non imporrà costi addizionali sul cliente e potrà essere accettata facilmente.

giovedì 10 dicembre 2009

I 7 peccati di Microsoft Windows 7

Non è passato molto tempo da una mia riflessione sul mondo dell'OpenSource, e ieri ho letto questo articolo molto interessante sulla mentalità (se così la si vuole chiamare) di Microsoft Windows 7.

E ancora c'è gente che mi vuole vendere la storia del se si rompe so a chi chiedere aiuto?

E ancora c'è gente che mi vuole vendere la storia del se si rompe so a chi chiedere aiuto?

lunedì 7 dicembre 2009

PGDay 2009: un altro evento di successo!

Sono molto soddisfatto del PGDay 2009 che si è tenuto a Pisa, presso l'Università.

Inizialmente ero un po' scettico, devo ammetterlo. Il fatto è che questo è stato un anno pesante, sia per i singoli soci (come me) dell'associazione promotrice (ITPug) che per l'associazione stessa. Eppure ancora una volta, i nostri sforzi hanno dato ottimi risultati.

L'atmosfera che si respirava fin dai primi momenti dell'evento era di festa, di voglia di scambiare idee e opinioni, di crescere condividendo esperienze.

L'affluenza è stata molto buona: circa 60 membri suddivisi fra aziende, privati, università ed enti pubblici. Si poteva fare di meglio, ma va anche considerato che il clima non ci ha certo aiutato (diversi sono rimasti intrappolati nel traffico e nella neve!).

Il Dipartimento di Informatica dell'Università di Pisa è bellissimo, uno dei piu' belli che abbia mai visto (e di facoltà ne ho girate diverse) e la gente è cordiale e disponibile. Le sale a nostra disposizione sono spaziose, luminose, ordinate e ben attrezzate.

Purtroppo si parte con un po' di ritardo, dovuto appunto a problemi climatici, ma poi tutta la giornata si articola in una unica discussione continua su PostgreSQL. L'interesse è alto, e piu' che nelle altre edizioni ho l'impressione che si stia realmente colpendo il pubblico. In un certo senso, era come se il pubblico fosse digiuno di PostgreSQL e rimanesse allibito vedendo con quale semplicità e velocità si potevano fare le cose di piu' alto livello.

Notevole la sezione dei lightning talks, che ha coinvolto praticamente tutti, e ha permesso di verificare che PostgreSQL non è poi un prodotto di nicchia, ma un prodotto molto utilizzato e molto apprezzato.

Penso che ancora una volta ITPug abbia mostrato, sul campo, che è capace di muovere eventi degni di nota. Certo questo non basta, si vuole crescere ancora ed essere in grado di promuovere eventi ancora piu' spettacolari o con maggiore frequenza, e per questo occorre il supporto di tutti i soci. Ma penso che, concretamente, l'associazione si stia comportando davvero bene.

Al prossimo PGDay!

Inizialmente ero un po' scettico, devo ammetterlo. Il fatto è che questo è stato un anno pesante, sia per i singoli soci (come me) dell'associazione promotrice (ITPug) che per l'associazione stessa. Eppure ancora una volta, i nostri sforzi hanno dato ottimi risultati.

L'atmosfera che si respirava fin dai primi momenti dell'evento era di festa, di voglia di scambiare idee e opinioni, di crescere condividendo esperienze.

L'affluenza è stata molto buona: circa 60 membri suddivisi fra aziende, privati, università ed enti pubblici. Si poteva fare di meglio, ma va anche considerato che il clima non ci ha certo aiutato (diversi sono rimasti intrappolati nel traffico e nella neve!).

Il Dipartimento di Informatica dell'Università di Pisa è bellissimo, uno dei piu' belli che abbia mai visto (e di facoltà ne ho girate diverse) e la gente è cordiale e disponibile. Le sale a nostra disposizione sono spaziose, luminose, ordinate e ben attrezzate.

Purtroppo si parte con un po' di ritardo, dovuto appunto a problemi climatici, ma poi tutta la giornata si articola in una unica discussione continua su PostgreSQL. L'interesse è alto, e piu' che nelle altre edizioni ho l'impressione che si stia realmente colpendo il pubblico. In un certo senso, era come se il pubblico fosse digiuno di PostgreSQL e rimanesse allibito vedendo con quale semplicità e velocità si potevano fare le cose di piu' alto livello.

Notevole la sezione dei lightning talks, che ha coinvolto praticamente tutti, e ha permesso di verificare che PostgreSQL non è poi un prodotto di nicchia, ma un prodotto molto utilizzato e molto apprezzato.

Penso che ancora una volta ITPug abbia mostrato, sul campo, che è capace di muovere eventi degni di nota. Certo questo non basta, si vuole crescere ancora ed essere in grado di promuovere eventi ancora piu' spettacolari o con maggiore frequenza, e per questo occorre il supporto di tutti i soci. Ma penso che, concretamente, l'associazione si stia comportando davvero bene.

Al prossimo PGDay!

Trenitalia e il warp temporale

A velocità diverse il tempo scorre in modo diverso (teoria della relatività).

Alla Trenitalia questa cosa la devono aver presa molto seriamente quando hanno compilato gli orari dei treni. Capita allora che, alla soglia del 2010, quando su tutte le emittenti ci sono pubblicità a raffiche sull'efficienza e l'eleganza dei nuovi servizi ad alta velocità, 15 minuti di ritardo su un treno si tramutino in circa 2 ore di ritardo sull'arrivo finale.

Mi è capitato infatti di dover andare a Pisa, per il PGDay 2009, e di aver viaggiato in ritardo di 15 minuti con il primo treno diretto a Fidenza; ritardo fatale perché mi ha impedito di prendere la coincidenza. Ho quindi deviato su un altro percorso suggeritomi dal capostazione. Ma anche il secondo treno, partito puntuale, è arrivato con circa 30 minuti di ritardo (avevo 37 minuti per prendere la terza coincidenza). Poco male, ho preso in tempo l'ultimo treno che è partito puntuale alla volta di Pisa...arrivando con 20 minuti di ritardo.

E io complessivamente sono arrivato invece che alle 21.30 (come indicato sui biglietti) alle 23.50!

Beh, se voglio viaggiare bene e puntuale posso spendere di piu' e usare la Freccia Rossa...ma perché devo pagare per avere un disservizio e arrivare con un simile ritardo?

venerdì 27 novembre 2009

SWT e class inheritance

I widget SWT non consentono l'eredità: al loro interno esiste un metodo (checkSubclass()) che effettua dei controlli per garantire che una sottoclasse non venga utilizzata in una applicazione.

Ovviamente questa è una restrizione a run-time, di fatto i componenti possono essere derivati da altri anche se poi non risulteranno utilizzabili a run-time.

Le motivazioni di questa scelta progettuale risiedono nella preferenza della composizione rispetto all'ereditarietà, e mi fa molto piacere vedere che esistano dei framework che si spingono in questa direzione.

Tuttavia ogni tanto è piu' comodo derivare widget da altri piuttosto che usare la composizione (che costringe l'utilizzo di interfacce e la costruzione di API wrapper), ma questo dovrebbe avvenire solo per widget per cui sia garantita la portabilità. Se non si vuole poi implementare la propria logica di controllo nel metodo checkSubclass() è necessario inserire i widgets in un package org.eclipse.swt.widgets.

Ovviamente questa è una restrizione a run-time, di fatto i componenti possono essere derivati da altri anche se poi non risulteranno utilizzabili a run-time.

Le motivazioni di questa scelta progettuale risiedono nella preferenza della composizione rispetto all'ereditarietà, e mi fa molto piacere vedere che esistano dei framework che si spingono in questa direzione.

Tuttavia ogni tanto è piu' comodo derivare widget da altri piuttosto che usare la composizione (che costringe l'utilizzo di interfacce e la costruzione di API wrapper), ma questo dovrebbe avvenire solo per widget per cui sia garantita la portabilità. Se non si vuole poi implementare la propria logica di controllo nel metodo checkSubclass() è necessario inserire i widgets in un package org.eclipse.swt.widgets.

Spring: RowMapper e avanzamento del ResultSet

I ResultSet passati ad un RowMapper di Spring sono già posizionati sulla prima riga utile, quindi non è necessario fare il classico ciclo alla JDBC:

while( rs.next() ){

...

}

Qualora si debba iterare fra piu' righe del ResultSet occorre convertire il ciclo in un do-while:

do{

...

}while( rs.next() );

while( rs.next() ){

...

}

Qualora si debba iterare fra piu' righe del ResultSet occorre convertire il ciclo in un do-while:

do{

...

}while( rs.next() );

SWT: Combo box con modello integrato

Il widget Combo della libreria SWT non consente l'inserimento nel drop down menu' di oggetti qualunque, ma solo di String. Questa è ovviamente una limitazione perché richiede che il combobox sia affiancato da un modello dati che consenta la correlazione fra indice selezionato e oggetto a cui ci si riferisce.

Creare un wrapper per il Combo che contenga un semplice modello dati lineare (monodimensionale) è un'operazione quasi banale. Nell'esempio sottostante si suppone che BusinessObject sia il capostipite degli oggetti che si vogliono selezionare tramite il Combo; questo wrapper rende il comportamento di Combo piu' simile al suo duale Swing JComboBox.

Creare un wrapper per il Combo che contenga un semplice modello dati lineare (monodimensionale) è un'operazione quasi banale. Nell'esempio sottostante si suppone che BusinessObject sia il capostipite degli oggetti che si vogliono selezionare tramite il Combo; questo wrapper rende il comportamento di Combo piu' simile al suo duale Swing JComboBox.

public class BusinessObjectCombo extends Combo {

public BusinessObjectCombo(Composite parent, int style) {

super(parent, style);

}

/**

* An internal list to keep track of all elements this combo is displaying.

*/

private List model = new LinkedList();

/**

* Provides the business object corresponding to the selected element in the combo.

* @return the business object from the combo

*/

public synchronized final BusinessObject getSelectedBusinessObject(){

// get the selected index

int index = this.getSelectionIndex();

// return the element from the model

return this.model.get(index);

}

/**

* Adds a new business object to the combo and to the internal model.

* @param newElement

*/

public synchronized final void add(BusinessObject newElement){

// check arguments

if( newElement == null )

return;

else{

// add the element to the list and to the combo

this.model.add(newElement);

this.add( newElement.toString() );

}

}

/**

* Removes the specified element from the combo.

* @param element

*/

public synchronized final void remove(BusinessObject element){

// get the index from the model

int index = this.model.indexOf(element);

if( index >= 0 ){

this.model.remove(index);

this.remove(index);

}

}

/**

* Clears all the elements from the combo and the internal model.

*/

public synchronized final void clear(){

this.model = new LinkedList();

this.removeAll();

}

/**

* Adds all the elements from the specified collection.

* @param businessObjects

*/

public synchronized final void addAll(Collection businessObjects ){

for( BusinessObject bo : businessObjects )

this.add( bo );

}

}

mercoledì 25 novembre 2009

if( opensource instanceof NonHaValore )

Questo non vuole essere un post-flame sull'OpenSource, e non ha nemmeno la pretesa di essere un post di evangelizzazione. Voglio solo enfatizzare un modello comune di pensiero, quasi un paradigma, che si è diffuso e che è difficile da sradicare in molti sviluppatori, designers, software house, ecc. E ovviamente è un paradigma che limita l'adozione dell'OpenSource.

Quando si parla di soluzioni OpenSource spesso si viene bloccati con affermazioni del tipo "ma se poi mi si rompe, o non va, io (il mio cliente, il cliente del mio cliente, l'amico del cliente del cliente, ...) a chi mi rivolgo?". Detta in altre parole: "vorrei tanto usare l'OpenSource, ma non ho le garanzie di una ditta commerciale alle spalle che mi possa offrire un servizio di assistenza".

E' vero!

Ma se parliamo di piccoli progetti OpenSource. Se parliamo di soluzioni di classi enterprise (qualche esempio: PostgreSQL, MySQL, Eclipse, OpenSolaris) allora le aziende alle spalle ci sono, i contratti di assistenza ci sono, i bugfix ci sono. Quello che manca, nella controparte, è la mentalità.

Le affermazioni della controparte possono essere riscritte con altre parole: "pago perché voglio la garanzia di un'assistenza futura".

Scusa ma cosa paghi?

Paghi il prodotto. Allora perché pagando il prodotto hai diritto all'assistenza futura? Perché paghi anche un contratto di assistenza, ma allora paghi il prodotto e l'assistenza.

E se l'azienda fallisce? Chi ti fornirà assistenza?

Ma le grosse aziende non falliscono! Molte volte questo è vero, ma molte volte le grosse aziende vengono inghiottite da aziende ancora piu' grosse (per fare un esempio si pensi al caso Oracle-MySQL). E in quei casi l'azienda potrebbe cambiare direzione, potrebbe smettere un prodotto considerato obsoleto o un doppione di un prodotto presente in entrambe le parti che partecipano alla fusione.

E l'interoperabilità? Beh, quella solitamente va a braccetto con l'OpenSource, perché se le applicazioni sono OpenSource allora gestire i dati e i flussi di dati risulta concretamente fattibile. Se le applicazioni sono closed-source allora tutto si complica, e spesso ci si deve affidare a programmi di import/export creati dall'azienda stessa o un suo partner. E questi non sempre hanno in mente le vostre esigenze, quindi siete spesso voi a dovervi piegare alle loro. Ma come, pagate il prodotto, pagate l'assistenza, e non ricevete nemmeno il classico servizio che anche un ristoratore vi offre (il cliente ha sempre ragione)?

Ma si sta scendendo nella polemica.

Quello che realmente secondo me deve essere enfatizzato è che la mentalità attuale porta a dire che se una cosa è OpenSource (o peggio ancora free) allora non ha valore. Se lo sviluppatore stesso non si fa pagare significa che non sa quanto valga, e comunque deve valere poco.

Io preferisco pensare che abbia talmente tanto valore da non essere misurabile, e che il vero business dietro all'OpenSource sia il servizio.

E metto in guardia i fanatici: non tutto deve rispettare le quattro libertà della licenza GNU GPL. Il Web 2.0 ha portato sistemi che non possono materialmente rispettare la freedom 0 (capacità di eseguire il programma). Ma questo non significa che si debba cedere sull'OpenSource!

Quando si parla di soluzioni OpenSource spesso si viene bloccati con affermazioni del tipo "ma se poi mi si rompe, o non va, io (il mio cliente, il cliente del mio cliente, l'amico del cliente del cliente, ...) a chi mi rivolgo?". Detta in altre parole: "vorrei tanto usare l'OpenSource, ma non ho le garanzie di una ditta commerciale alle spalle che mi possa offrire un servizio di assistenza".

E' vero!

Ma se parliamo di piccoli progetti OpenSource. Se parliamo di soluzioni di classi enterprise (qualche esempio: PostgreSQL, MySQL, Eclipse, OpenSolaris) allora le aziende alle spalle ci sono, i contratti di assistenza ci sono, i bugfix ci sono. Quello che manca, nella controparte, è la mentalità.

Le affermazioni della controparte possono essere riscritte con altre parole: "pago perché voglio la garanzia di un'assistenza futura".

Scusa ma cosa paghi?

Paghi il prodotto. Allora perché pagando il prodotto hai diritto all'assistenza futura? Perché paghi anche un contratto di assistenza, ma allora paghi il prodotto e l'assistenza.

E se l'azienda fallisce? Chi ti fornirà assistenza?

Ma le grosse aziende non falliscono! Molte volte questo è vero, ma molte volte le grosse aziende vengono inghiottite da aziende ancora piu' grosse (per fare un esempio si pensi al caso Oracle-MySQL). E in quei casi l'azienda potrebbe cambiare direzione, potrebbe smettere un prodotto considerato obsoleto o un doppione di un prodotto presente in entrambe le parti che partecipano alla fusione.

E l'interoperabilità? Beh, quella solitamente va a braccetto con l'OpenSource, perché se le applicazioni sono OpenSource allora gestire i dati e i flussi di dati risulta concretamente fattibile. Se le applicazioni sono closed-source allora tutto si complica, e spesso ci si deve affidare a programmi di import/export creati dall'azienda stessa o un suo partner. E questi non sempre hanno in mente le vostre esigenze, quindi siete spesso voi a dovervi piegare alle loro. Ma come, pagate il prodotto, pagate l'assistenza, e non ricevete nemmeno il classico servizio che anche un ristoratore vi offre (il cliente ha sempre ragione)?

Ma si sta scendendo nella polemica.

Quello che realmente secondo me deve essere enfatizzato è che la mentalità attuale porta a dire che se una cosa è OpenSource (o peggio ancora free) allora non ha valore. Se lo sviluppatore stesso non si fa pagare significa che non sa quanto valga, e comunque deve valere poco.

Io preferisco pensare che abbia talmente tanto valore da non essere misurabile, e che il vero business dietro all'OpenSource sia il servizio.

E metto in guardia i fanatici: non tutto deve rispettare le quattro libertà della licenza GNU GPL. Il Web 2.0 ha portato sistemi che non possono materialmente rispettare la freedom 0 (capacità di eseguire il programma). Ma questo non significa che si debba cedere sull'OpenSource!

Compile time constraints and runtime constraints: WhiteCat merges both!

Due to the reviews on a WhiteCat paper I received, and the claims from a colleague of mine, I decided to write a little post about my way of thinking OOP and how I conceive it with WhiteCat.

I started developing serious applications using Java version 1. If you remember, at that time there were no fancy features, so the only thing you could have to do to decouple your code was to have a good OOP design. What is a good OOP design? It is a strictly typed system.

Am I a strictly-typed kind of developer? Yes.

In my early stage of software designer I was used to create classes and interfaces as it was raining cats and dogs! Then I read THE book about Perl (Programming Perl) and a statement by Larry Wall really impressed me: Larry wrote that there must a balance between programming-in-a-rush and programming-by-presumption. What does it mean? It means (to me) that if you are a pure OOP designer/developer you will start thinking that you are not developing only a piece of software to solve an assigned problem, but you are creating a creature that everybody could/would use. This leads to a class/interface storm, since you are taking into account every possible use of your piece of software. I was such a developer!

Now I've changed my mind, and I've found a good balance between rush and presumption.

How does my OOP mindset connect to the WhiteCat approach? Well, of course WhiteCat is a creature of mine, and therefore it has been developed following my ideas and design/developing habits. But this of course not the answer you want to read.

WhiteCat is a very dynamic system, and usually dynamism is at the opposite of strong typing (think to Python for instance). Since I am a strictly-typed designer/developer, how can I accept a very dynamic system like WhiteCat?

Short answer: Liskov substitution principle is guarantee to work, so the type system is ensured to work.

Do you need a more detailed answer?

When you compile an application you accept the compiler rules. A strict compiler leads to a typed system (secure), while a weak compiler leads to an untyped system (more dynamic, less secure).

WhiteCat agents, roles, and framework itself is compiled thru a standard Java compiler (well, to be onest thru an AspectJ one), so WhiteCat components obey the same compiler rule.

But WhiteCat allows developers to dynamically change the class definition at runtime; does it means that compile rules are overtaken? No, since WhiteCat guarantees the Liskov substitution principle to work. But this is not all folks: WhiteCat imposes compile-time constraints at runtime! This is the very soul of WhiteCat: being able to start from a strongly-typed system (your agents/role compiled thru a Java compiler) and to modify them at runtime as they were compiled in a different way (i.e., starting from modified sources).

So WhiteCat starts from a typed system and leads to a typed system, but in the middle it is able to change the types in order to improve your agents/roles.

Was this the same as RoleX (a.k.a. BlackCat) did? No, because BlackCat was changing dynamically the agent class making the Liskov substitution principle not applicable. In other words, BlackCat was very dynamic, but started from a typed system to get to an untyped (and unmanageable) system. This is the real difference between WhiteCat and BlackCat.

I started developing serious applications using Java version 1. If you remember, at that time there were no fancy features, so the only thing you could have to do to decouple your code was to have a good OOP design. What is a good OOP design? It is a strictly typed system.

Am I a strictly-typed kind of developer? Yes.

In my early stage of software designer I was used to create classes and interfaces as it was raining cats and dogs! Then I read THE book about Perl (Programming Perl) and a statement by Larry Wall really impressed me: Larry wrote that there must a balance between programming-in-a-rush and programming-by-presumption. What does it mean? It means (to me) that if you are a pure OOP designer/developer you will start thinking that you are not developing only a piece of software to solve an assigned problem, but you are creating a creature that everybody could/would use. This leads to a class/interface storm, since you are taking into account every possible use of your piece of software. I was such a developer!

Now I've changed my mind, and I've found a good balance between rush and presumption.

How does my OOP mindset connect to the WhiteCat approach? Well, of course WhiteCat is a creature of mine, and therefore it has been developed following my ideas and design/developing habits. But this of course not the answer you want to read.

WhiteCat is a very dynamic system, and usually dynamism is at the opposite of strong typing (think to Python for instance). Since I am a strictly-typed designer/developer, how can I accept a very dynamic system like WhiteCat?

Short answer: Liskov substitution principle is guarantee to work, so the type system is ensured to work.

Do you need a more detailed answer?

When you compile an application you accept the compiler rules. A strict compiler leads to a typed system (secure), while a weak compiler leads to an untyped system (more dynamic, less secure).

WhiteCat agents, roles, and framework itself is compiled thru a standard Java compiler (well, to be onest thru an AspectJ one), so WhiteCat components obey the same compiler rule.

But WhiteCat allows developers to dynamically change the class definition at runtime; does it means that compile rules are overtaken? No, since WhiteCat guarantees the Liskov substitution principle to work. But this is not all folks: WhiteCat imposes compile-time constraints at runtime! This is the very soul of WhiteCat: being able to start from a strongly-typed system (your agents/role compiled thru a Java compiler) and to modify them at runtime as they were compiled in a different way (i.e., starting from modified sources).

So WhiteCat starts from a typed system and leads to a typed system, but in the middle it is able to change the types in order to improve your agents/roles.

Was this the same as RoleX (a.k.a. BlackCat) did? No, because BlackCat was changing dynamically the agent class making the Liskov substitution principle not applicable. In other words, BlackCat was very dynamic, but started from a typed system to get to an untyped (and unmanageable) system. This is the real difference between WhiteCat and BlackCat.

Etichette:

programmazione,

research,

WhiteCat

venerdì 6 novembre 2009

PGDay 2009

Ebbene anche quest'anno ci siamo: ITPug sta organizzando (assieme a tutti i volontari e gli appassionati di PostgreSQL) l'edizione 2009 del PGDay (PostgreSQL Day).

Questa edizione, a differenza di quelle passate, sarà a solo carattere nazionale (il PGDay Europeo si sta svolgendo in questi giorni in Francia). Questo però non significa che la qualità tecnica del meeting sarà inferiore a quella degli altri anni, anzi...basta dare un'occhiata al programma (ancora in costruzione) per accorgersi che non manca davvero nulla per iniziare ad usare o approfondire la propria conoscenza di questo RDBMS.Forza ragazzi, diamoci da fare!

mercoledì 14 ottobre 2009

Fixed a bug in the array class loading

Thanks to the effort of a friend of mine, Fernando, involved in the Aglets development, a bug about the class loading of an array of objects have been fixed. Today I commited the new code to the git repository.

The bug caused an agent, using an array of objects, to be not loaded well after a migration; the problem was that the Aglets class loader was unable to load the class of the array and instantiate, consequently, the array itself. This happened with a recent JVM (e.g., 1.6) and not with older ones, due to some minor changes in the new JVM array handling.

The bug caused an agent, using an array of objects, to be not loaded well after a migration; the problem was that the Aglets class loader was unable to load the class of the array and instantiate, consequently, the array itself. This happened with a recent JVM (e.g., 1.6) and not with older ones, due to some minor changes in the new JVM array handling.

Installare KDE 4 su OpenSolaris

OpenSolaris è un sistema che mi sta affascinando ogni giorno di piu', ma da buon utente KDE mi trovo un po' spaesato con il desktop GNOME (il default su OpenSolaris), così ho cercato le istruzioni per installare il mio desktop preferito.

Inizialmente mi sono imbattuto nella pagina ufficiale di KDE su OpenSolaris, ma ahimé senza successo. Il problema, mi verrà spiegato poi, è che il repository IPS indicato non e' piu' disponibile, e quindi ho dovuto ripiegare su una versione di un altro repository.

I comandi da lanciare nel terminale di un OpenSolaris 2009.06 sono i seguenti:

pfexec pkg set-authority -O http://solaris.bionicmutton.org:10000 bionicmutton

pfexec pkg refresh

pfexec pkg install qt

pfexec pkg install KDEBase-apps KDEgdm-integration

Inizialmente mi sono imbattuto nella pagina ufficiale di KDE su OpenSolaris, ma ahimé senza successo. Il problema, mi verrà spiegato poi, è che il repository IPS indicato non e' piu' disponibile, e quindi ho dovuto ripiegare su una versione di un altro repository.

I comandi da lanciare nel terminale di un OpenSolaris 2009.06 sono i seguenti:

pfexec pkg set-authority -O http://solaris.bionicmutton.org:10000 bionicmutton

pfexec pkg refresh

pfexec pkg install qt

pfexec pkg install KDEBase-apps KDEgdm-integration

venerdì 25 settembre 2009

Che maleducazione!

L'altra sera il treno che mi doveva portare a casa si è fermato per quasi un'ora in stazione a causa di un black-out elettrico. Noi passeggeri siamo tutti scesi e ci siamo messi ad aspettare sotto le pensiline, così che il treno è rimasto vuoto.

Ad un certo punto ho sentito uno dei controllori gridare e ho assistito ad una scena realmente raccapricciante: un extracomunitario era risalito su uno dei vagoni per urinare (all'interno del vagone, fra i sedili!).

Essendo stato cappellato l'uomo è sceso dal treno e come nulla fosse si è messo in un angolo attendendo che il treno ripartisse, incurante delle urla del capotreno. Ed è ripartito regolarmente con il treno appena è stato possibile!

Ora mi domando: erano forse i bagni della stazione troppo lontani per lui? Era forse quel cespuglio che si trova accanto ai binari troppo scomodo per lui?

E non era forse il caso di chiamare anche una qualche guardia per meglio fargli comprendere la gravità del suo gesto?

E poi facciamo spot televisi e trasmissioni proclamando l'importanza dell'igiene e del lavarsi spesso le mani...

Ad un certo punto ho sentito uno dei controllori gridare e ho assistito ad una scena realmente raccapricciante: un extracomunitario era risalito su uno dei vagoni per urinare (all'interno del vagone, fra i sedili!).

Essendo stato cappellato l'uomo è sceso dal treno e come nulla fosse si è messo in un angolo attendendo che il treno ripartisse, incurante delle urla del capotreno. Ed è ripartito regolarmente con il treno appena è stato possibile!

Ora mi domando: erano forse i bagni della stazione troppo lontani per lui? Era forse quel cespuglio che si trova accanto ai binari troppo scomodo per lui?

E non era forse il caso di chiamare anche una qualche guardia per meglio fargli comprendere la gravità del suo gesto?

E poi facciamo spot televisi e trasmissioni proclamando l'importanza dell'igiene e del lavarsi spesso le mani...

mercoledì 29 luglio 2009

New GIT repository for Aglets

After a quite long suffering with the CVS repository provided by SourceForge, I moved the Aglets code base to a GIT repository, still hosted at SourceForge (see the official news).

I haven't moved the official CVS module aglets, but instead I've integrated my own branch which includes the new threading scheme, the new GUI (based on Swing), the new message queueing and the full localization of all messages.

I hope this change will ease the development and, in the meantime, attract new developers to work on the code base. Quite surprisingly the number of project members is growing, even if the commits are not, but of course there must be time for new members to learn the code before they can work on it!

At the moment the documentation is still on the CVS repository, but I guess it will be migrated sooner or later. The CVS repository is still active, in order to allow GIT-newbies to take a look at the code without having to use GIT, but CVS will be disabled soon so I recommend using the GIT repository instead.

I haven't moved the official CVS module aglets, but instead I've integrated my own branch which includes the new threading scheme, the new GUI (based on Swing), the new message queueing and the full localization of all messages.

I hope this change will ease the development and, in the meantime, attract new developers to work on the code base. Quite surprisingly the number of project members is growing, even if the commits are not, but of course there must be time for new members to learn the code before they can work on it!

At the moment the documentation is still on the CVS repository, but I guess it will be migrated sooner or later. The CVS repository is still active, in order to allow GIT-newbies to take a look at the code without having to use GIT, but CVS will be disabled soon so I recommend using the GIT repository instead.

giovedì 23 luglio 2009

Happy Birthday JPUG!

Il 23 Luglio è una data importante per il Japan PostgreSQL Users' Group (JPUG): dieci anni fa nasceva infatti questa associazione per la promozione e la divulgazione di PostgreSQL in Giappone.

E' dietro la spinta di Mr. Ohtani e Mr. Tado, che la comunità di utenti di una mailing list tecnica (pgsql-jp) si aggrega fino a diventare una associazione per la divulgazione di PostgreSQL. E in questi dieci anni JPUG ha contribuito notevolmente alla crescita degli utenti PostgreSQL, basti pensare che questo è il database maggiormente utilizzato in Giappone (e anche il primo ad essere supportato da Ruby!).

Per celebrare il decennale di JPUG dal 20 al 21 Novembre 2009 si terrà a Tokyo una conferenza interamente dedicata a PostgreSQL.

Avendo conosciuto due membri del JPUG, Hiroshi Saito e Ishikawa Toshiyuki, posso confermare il profondo interesse e la grande serietà delle persone che lavorano per JPUG.

E' dietro la spinta di Mr. Ohtani e Mr. Tado, che la comunità di utenti di una mailing list tecnica (pgsql-jp) si aggrega fino a diventare una associazione per la divulgazione di PostgreSQL. E in questi dieci anni JPUG ha contribuito notevolmente alla crescita degli utenti PostgreSQL, basti pensare che questo è il database maggiormente utilizzato in Giappone (e anche il primo ad essere supportato da Ruby!).

Per celebrare il decennale di JPUG dal 20 al 21 Novembre 2009 si terrà a Tokyo una conferenza interamente dedicata a PostgreSQL.

Avendo conosciuto due membri del JPUG, Hiroshi Saito e Ishikawa Toshiyuki, posso confermare il profondo interesse e la grande serietà delle persone che lavorano per JPUG.

martedì 30 giugno 2009

Setter, Getter o entrambi?

I Java Beans hanno introdotto diverse convenzioni, fra le quali quelle circa l'utilizzo dei metodi getter e setter: i primi sono metodi che ritornano il valore di un attributo d'istanza, i secondi sono mutator che impostano il valore di tale attributo. La convenzione vuole che il getter abbia un nome che inizia con get, seguito dal nome della proprietà (variabile di istanza) con la prima lettera maiuscola e non abbia alcun parametro, ma ritorni un tipo pari a quello della proprietà. Il setter segue regole simili, e ha il suo nome composto da set e il nome della proprietà (prima lettera maiuscola) e riceva esattamente un argomento del tipo della proprietà senza ritornare al chiamante nulla.

Da quanto sopra si ha che per ogni proprietà servono almeno due metodi distinti, un getter e un setter, abbastanza semplici e rapidi da scrivere (addirittura gli IDE moderni consentono di creare tali metodi con un click). E' però possibile prendere in prestito da Perl il comportamento dei metodi e scrivere un metodo unico che svolga entrambe le funzioni.

Si consideri la seguente semplice classe:

Come si può notare il metodo name viene chiamato in due contesti diversi: se gli viene passato un parametro si deve comportare come setter, altrimenti come getter.

Come si puo' ottenere un simile comportamento? Usando gli argomenti opzionali introdotti da Java 5 è abbastanza semplice:

Come si può notare il metodo si comporta come getter sempre, ovvero restituisce sempre il valore della proprietà name. Il metodo poi indovina il contesto di chiamata analizzando gli eventuali parametri: se ne sono stati passati al massimo uno allora il metodo si deve comportare come setter. E' possibile rilassare il test sul numero di parametri considerando valida una lista di parametri qualsivoglia lunga, e usando solo il primo come setter, ma questa scelta dipende dall'interfaccia che si vuole dare al metodo.

Il fatto che il metodo restituisca sempre, anche se chiamato in un contesto di setter, il valore della proprietà non è una limitazione, anzi consente di effettuare un method-chain invocando piu' metodi in cascata.

Da quanto sopra si ha che per ogni proprietà servono almeno due metodi distinti, un getter e un setter, abbastanza semplici e rapidi da scrivere (addirittura gli IDE moderni consentono di creare tali metodi con un click). E' però possibile prendere in prestito da Perl il comportamento dei metodi e scrivere un metodo unico che svolga entrambe le funzioni.

Si consideri la seguente semplice classe:

public class Person {

private String name = null;

private String surname = null;

...

}

e si supponga di voler scrivere un unico metodo name che possa funzionare sia da getter che da setter a seconda del contesto in cui viene chiamato. In altre parole il seguente main deve funzionare:public static void main(String[] args) {

Person p = new Person();

p.name( "Luca" );

System.out.println("Persona " + p.name() );

}

Come si può notare il metodo name viene chiamato in due contesti diversi: se gli viene passato un parametro si deve comportare come setter, altrimenti come getter.

Come si puo' ottenere un simile comportamento? Usando gli argomenti opzionali introdotti da Java 5 è abbastanza semplice:

public String name(String...newName){

// controllo se e' stato passato

// un parametro o meno

if( newName != null && newName.length == 1 )

// passato un parametro => metodo setter

this.name = newName[0];

// in ogni caso ritorno il valore

// corrente come metodo getter

return this.name;

}

Come si può notare il metodo si comporta come getter sempre, ovvero restituisce sempre il valore della proprietà name. Il metodo poi indovina il contesto di chiamata analizzando gli eventuali parametri: se ne sono stati passati al massimo uno allora il metodo si deve comportare come setter. E' possibile rilassare il test sul numero di parametri considerando valida una lista di parametri qualsivoglia lunga, e usando solo il primo come setter, ma questa scelta dipende dall'interfaccia che si vuole dare al metodo.

Il fatto che il metodo restituisca sempre, anche se chiamato in un contesto di setter, il valore della proprietà non è una limitazione, anzi consente di effettuare un method-chain invocando piu' metodi in cascata.

mercoledì 24 giugno 2009

Creare un modulo per il kernel di Linux

Questo breve articolo mostra come creare e caricare un semplice modulo per il kernel di Linux, in modo da dare accesso alle funzionalità del kernel.

Un modulo deve essere scritto in linguaggio C, compilato in un modo un po' particolare (ma tutto sommato semplice) e installato e rimosso mediante i comandi insmod, depmod e similari.

Vediamo subito il codice di un modulo che viene caricato in memoria e appena attivato stampa la classica frase Hello World:

La compilazione del modulo avviene tramite il seguente Makefile:

Per installarlo basta usare il comando insmod:

Una volta installato il modulo (è possibile controllarne l'installazione con lsmod) si possono vedere i primi messaggi del kernel. Un dmesg mostra infatti la stampa della funzione di inizializzazione.

Rimuovendo poi il modulo con:

Un modulo deve essere scritto in linguaggio C, compilato in un modo un po' particolare (ma tutto sommato semplice) e installato e rimosso mediante i comandi insmod, depmod e similari.

Vediamo subito il codice di un modulo che viene caricato in memoria e appena attivato stampa la classica frase Hello World:

La parte relativa agli header, come pure i prototipi delle funzioni, sono standard. In particolare init_module viene richiamata al momento dell'installazione del modulo, mentre cleanup_module al momento della sua rimozione./* Declare what kind of code we want from the header files */

#define __KERNEL__ /* We're part of the kernel */

#define MODULE /* Not a permanent part, though. */

#include

/* Initialize the LKM */

int init_module()

{

printk("Modulo in fase di inizializzazione...\n");

printk("\nHELLO WORLD!\n");

/* If we return a non zero value, it means that

* init_module failed and the LKM can't be loaded

*/

return 0;

}

/* Cleanup − undo whatever init_module did */

void cleanup_module(){

printk("Modulo in fase di uscita\n");

printk("\nBYE BYE WORLD");

}

La compilazione del modulo avviene tramite il seguente Makefile:

Una volta compilato il modulo, sarà disponibile un file .ko (Kernel Object) che può essere caricato nel sistema. Siccome stiamo parlando di un semplice modulo di prova, anziché installare il modulo direttamente nella directory modules possiamo installare e rimuoverlo manualmente.obj-m := HelloWorld.o

KDIR := /lib/modules/$(shell uname -r)/build

PWD := $(shell pwd)

default:

$(MAKE) -C $(KDIR) SUBDIRS=$(PWD) modules

Per installarlo basta usare il comando insmod:

insmod ./HelloWorld.ko

Una volta installato il modulo (è possibile controllarne l'installazione con lsmod) si possono vedere i primi messaggi del kernel. Un dmesg mostra infatti la stampa della funzione di inizializzazione.

Rimuovendo poi il modulo con:

rmmod HelloWorldsi avrà lo scaricamento dalla memoria del modulo e la scrittura fra i messaggi del kernel che la funzione di chiusura del modulo è stata richiamata.

lunedì 22 giugno 2009

Programmazione a oggetti in Perl

Perl è un linguaggio molto elegante e potente, che viene spesso insegnato per evidenziare concetti un po' più evoluti riguardo lo scripting.

Pur supportando la programmazione ad oggetti, Perl non fornisce alcun costrutto particolare per la realizzazione di classi e tipi di dato astratto. Si può paragonare Perl a un C che viene programmato ad-hoc per implementare un comportamento ad oggetti.

Imparare a programmare Perl a oggetti è molto interessante, soprattutto perché permette di vedere effettivamente come molti compilatori a oggetti si comportano. Inoltre gran parte della libreria Perl/CPAN è orientata agli oggetti, e quindi è indispensabile avere nozioni di OOP. Non è comunque facile trovare una guida sulla programmazione OOP in Perl, perciò ho deciso di scrivere questo articolo introduttivo. Da notare che farò riferimento a versioni di Perl inferiori alla 6, dove la scrittura di classi e oggetti cambierà grazie alla presenza di apposite parole chiave.

Il seguente elenco mostra i punti per me fondamentali da tenere a mente quando si vuole implementare una classe e di conseguenza usare degli oggetti.

Gli oggetti possono essere acceduti solo per riferimento.

Ogni istanza di oggetto viene mantenuta in un riferimento, in maniera simile a come avviene in Java.

Un riferimento ad un oggetto è un normale riferimento scalare.

Come i riferimenti alle strutture dati native (hash, array) sono contenuti in variabili scalari, così pure i riferimenti agli oggetti sono mantenuti in variabili scalari.

Una classe corrisponde ad uno spazio dei nomi, e quindi si implementa tramite un package.

In Perl una classe è una entità sul quale sono richiamati dei metodi. Per la precisione, un metodo di classe è un metodo al quale viene passato un parametro che indica lo spazio dei nomi nel quale si agisce. Ecco quindi che assegnare un metodo ad una classe corrisponde ad inserire un metodo in un determinato package: il metodo potrà essere invocato solo nell'ambito di quello spazio dei nomi (classe/package).

Se la struttura dati dell'oggetto è complessa, allora essa deve essere realizzata tramite un array o un hash, e il riferimento all'oggetto diventa il riferimento all'array/hash.

Questo punto va chiarito bene: in Perl esistono solo tre tipi di variabili (scalari, array, hash) e una classe sarà presumibilmente composta da diverse variabili di tale tipo. Dovendo però usare un riferimento ordinario (si vedano i punti precedenti) per l'oggetto, si ha che tale riferimento deve essere il punto di ingresso di una struttura più complessa. Di conseguenza, il riferimento all'oggetto deve essere un riferimento ad un array/hash che contenga tutte le altre variabili di istanza. Per meglio comprendere, se in Java una definizione di classe Person potrebbe essere così strutturata:

In Perl non potrebbe avere la definizione duale, ossia:

In questo modo la variabile $this consente accesso ai valori di name e surname, ed è possibile ritornare all'esterno un singolo riferimento a $this.

Da notare che la seguente traduzione non funziona come ci si aspetta:

Infatti così facendo si ha l'esistenza di uniche variabili $name e $surname e di conseguenza i riferimenti di ogni oggetto creato puntano alle stesse variabili globali (all'interno del package) e quindi agli stessi valori. La soluzione di cui sopra è invece appropriata per variabili statiche (ossia condivise all'interno di ogni classe).

Un metodo di classe o di oggetto riceve sempre in automatico un primo argomento che specifica la classe o l'istanza.

Questa cosa non dovrebbe stupire particolarmente, poiché è già quello che avviene nei normali compilatori ad oggetti: il primo parametro di un metodo di istanza è il puntatore/riferimento all'istanza stessa. E' in questo modo che i compilatori predispongono la variabile this. In altre parole, il metodo Java seguente:

Da notare che il primo parametro, di nome simbolico this, è un riferimento all'oggetto stesso. In altre parole i metodi di istanza ottengon come parametro la zona di memoria (o meglio il riferimento a tale zona) dove risiede l'oggetto sul quale si agisce. Perl segue lo stesso percorso: il primo argomento di un metodo di istanza contiene il riferimento all'oggetto stesso, di modo che il metodo possa essere scritto come:

Quanto sopra per quello che riguarda gli oggetti, ma per le classi?

In un linguaggio OOP come Java/C++ i metodi di classe (es. static) non necessitano di nessun argomento particolare o di modifiche da parte del compilatore. Infatti quello che avviene è che viene tenuta in memoria la tabella di dispatching dei metodi e l'invocazione di un metodo corrisponde al salto all'indirizzo fornito da questa tabella. Ma il metodo non ha bisogno di sapere se appartiene ad una classe oppure no, come non ha bisogno di sapere a che classe appartiene poiché per forza di cose, se non è di istanza, deve essere di classe.

In Perl questo non è vero: essendo una classe implementata tramite un package, i metodi all'interno del package potrebbero essere di istanza, oppure di classe, oppure nessuno dei due (normali metodi globali). Perl allora fornisce un modo per informare un metodo che è stato invocato in un contesto di classe (ossia come se fosse un metodo di classe): questo metodo riceverà infatti come primo argomento il nome (stringa) della classe/package al quale appartiene.

Riassumendo quindi, tutti i metodi di classe o di oggetto in Perl ricevono come primo argomento una variabile che indica il nome della classe (metodo di classe) o il riferimento all'oggetto stesso (metodo di oggetto) e non ricevono nulla se sono chiamati in un normale contesto di package.

In Perl non esiste il concetto di costruttore (e di distruttore).

Siccome Perl non fornisce nessuna parole chiave per definire una classe, i metodi costruttori (e distruttori) non esistono. Questo non significa che non si possano creare dei metodi appositi per l'inizializzazione delle variabili di un oggetto. Tali metodi dovranno ovviamente restituire al chiamante il riferimento alla struttura dati dell'oggetto.

Un metodo usato come costruttore non deve avere lo stesso nome della classe.

Siccome questi metodi non sono dei veri e propri costruttori, non devono seguire le regole standard dei costruttori Java e C++: essi possono (o meglio devono) avere un tipo di ritorno (solitamente il riferimento alla struttura dati dell'oggetto) e possono avere un nome non vincolante (solitamente new).

In Perl non esiste l'operatore new.

Quando si incontra qualcosa che assomiglia all'operatore new per l'allocazione di un oggetto, si sta in effetti osservando la chiamata di un metodo di nome new (si veda il punto precedente).

Il compilatore passa automaticamente ad un metodo il primo argomento (nome della classe o riferimento ai dati) quando si usa l'operatore freccia.

Quando la chiamata ad un metodo avviene attraverso l'operatore freccia, il compilatore passa come primo argomento del metodo l'oggetto lvalue su cui viene applicato l'operatore freccia. In altre parole:

corrisponde a:

e analogamente, una invocazione di metodo di oggetto può essere scritta come:

Il costruttore di un oggetto non deve solo inizializzare l'oggetto e il suo stato, ma deve anche informare Perl che il riferimento non è un normale riferimento ma un collegamento ad un oggetto. Questo avviene tramite l'operatore bless, che accetta il riferimento ad una struttura dati e la classe/package a cui la struttura dati appartiene. L'operatore memorizza in una tabella il collegamento fra il riferimento e il nome del package/classe a cui è associato, in modo da poter individuare a quale classe il riferimento appartiene. In particolare, in seguito al blessing, l'operatore ref applicato ad un riferimento di oggetto restituisce il nome della classe per la quale è stato fatto il blessing.

Sulla base di questa considerazione, il template generale per un costruttore di oggetto è il seguente:

Sulla base di tutti i punti di cui sopra, è possibile paragonare la creazione di una classe/oggetto fra un linguaggio OOP (es. Java) e Perl. Supponiamo di avere la seguente classe Java:

e di volerla tradurre in Perl. La sua definizione diviene la seguente:

che produce il seguente output:

Ereditarietà e Polimorfismo

L'ereditarietà in Perl viene implementata in modo molto semplice: è disponibile un array globale all'interno dello spazio dei nomi di un package, denominato ISA, che contiene le classi/package dalle quali si vuole ereditare. L'idea quindi è semplice: ogni package definisce una lista di ulteriori package in cui cercare dati e/o metodi. Quando Perl non trova un attributo nel package specificato inizia ad esplorare (sequenzialmente) l'array ISA al fine di trovare in ogni classe specificata il simbolo, e quindi lo utilizza.

Per meglio comprendere questo concetto, si consideri di estendere la classe Person con una classe Male che implementa una persona di sesso maschile:

Come si può notare la definizione del costruttore è praticamente la stessa della classe Person, addirittura si referenzia un simbolo ($personCounter) che qui non è stato ancora definito. Ora se un programma crea un nuovo oggetto di tipo Male:

l'output di esecuzione è del tutto simile a quello del programma precedente, e addirittura la variabile $personCounter inizia il suo conteggio come fosse separata dalla classe Person (ovvero come fosse stata definita singolarmente di classe). Tutta la magia viene fatta nella ricerca dei simboli, che anziché passare per una vtable passa per l'array ISA del package corrente (ogni package può ridefinire il proprio @ISA).

La ridefinizione dei metodi è automatica, quindi se si ridefinisce il seguente metodo nella classe Male si ha che la chiamata a getNome() verrà risolta da tale metodo:

Si noti che quando si usa SUPER la parte a destra viene sempre invocata con la sintassi di package (::) mentre quella di sinistra con la sintassi ad oggetto (->).

Per concludere

Riassumendo quindi si ha che in Perl la programmazione ad oggetti viene attualmente implementata tenendo separati i metodi e i dati, in modo piuttosto esplicito. Il riferimento ai dati rappresenta il riferimento all'oggetto (e quindi al suo stato), mentre l'invocazione dei metodi avviene grazie all'operatore freccia, che impone al compilatore di passare l'entità di sinistra (il riferimento o il nome della classe) come primo argomento. Grazie poi ad una tabella dei simboli gestita tramite l'operatore bless si ha l'associazione fra riferimento ai dati e classe, e questo consente, in combinazione all'array @ISA di sfruttare anche l'ereditarietà e il polimorfismo.

Pur supportando la programmazione ad oggetti, Perl non fornisce alcun costrutto particolare per la realizzazione di classi e tipi di dato astratto. Si può paragonare Perl a un C che viene programmato ad-hoc per implementare un comportamento ad oggetti.

Imparare a programmare Perl a oggetti è molto interessante, soprattutto perché permette di vedere effettivamente come molti compilatori a oggetti si comportano. Inoltre gran parte della libreria Perl/CPAN è orientata agli oggetti, e quindi è indispensabile avere nozioni di OOP. Non è comunque facile trovare una guida sulla programmazione OOP in Perl, perciò ho deciso di scrivere questo articolo introduttivo. Da notare che farò riferimento a versioni di Perl inferiori alla 6, dove la scrittura di classi e oggetti cambierà grazie alla presenza di apposite parole chiave.

Il seguente elenco mostra i punti per me fondamentali da tenere a mente quando si vuole implementare una classe e di conseguenza usare degli oggetti.

Gli oggetti possono essere acceduti solo per riferimento.

Ogni istanza di oggetto viene mantenuta in un riferimento, in maniera simile a come avviene in Java.

Un riferimento ad un oggetto è un normale riferimento scalare.

Come i riferimenti alle strutture dati native (hash, array) sono contenuti in variabili scalari, così pure i riferimenti agli oggetti sono mantenuti in variabili scalari.

Una classe corrisponde ad uno spazio dei nomi, e quindi si implementa tramite un package.

In Perl una classe è una entità sul quale sono richiamati dei metodi. Per la precisione, un metodo di classe è un metodo al quale viene passato un parametro che indica lo spazio dei nomi nel quale si agisce. Ecco quindi che assegnare un metodo ad una classe corrisponde ad inserire un metodo in un determinato package: il metodo potrà essere invocato solo nell'ambito di quello spazio dei nomi (classe/package).

Se la struttura dati dell'oggetto è complessa, allora essa deve essere realizzata tramite un array o un hash, e il riferimento all'oggetto diventa il riferimento all'array/hash.

Questo punto va chiarito bene: in Perl esistono solo tre tipi di variabili (scalari, array, hash) e una classe sarà presumibilmente composta da diverse variabili di tale tipo. Dovendo però usare un riferimento ordinario (si vedano i punti precedenti) per l'oggetto, si ha che tale riferimento deve essere il punto di ingresso di una struttura più complessa. Di conseguenza, il riferimento all'oggetto deve essere un riferimento ad un array/hash che contenga tutte le altre variabili di istanza. Per meglio comprendere, se in Java una definizione di classe Person potrebbe essere così strutturata:

public class Person{

private String name = null;

private String surname = null;

} In Perl non potrebbe avere la definizione duale, ossia:

poiché, così facendo, si avrebbe che lo spazio dei nomi della persona (Person) contiene due variabili scalari, ed è impossibile ritornare un singolo riferimento che fornisca accesso ad entrambe le variabili. E' quindi necessario incapsulare le variabili di classe all'interno di un unico contenitore e fornire accesso attraverso tale contenitore:package Person;

$name = undef();

$surname = undef();

package Person;

...

$this = { name => undef(),

surname => undef(),

};

In questo modo la variabile $this consente accesso ai valori di name e surname, ed è possibile ritornare all'esterno un singolo riferimento a $this.

Da notare che la seguente traduzione non funziona come ci si aspetta:

package Person;

$name = undef();

$surname = undef();

$this = { name => \$name,

surname => \$surname,

};

Infatti così facendo si ha l'esistenza di uniche variabili $name e $surname e di conseguenza i riferimenti di ogni oggetto creato puntano alle stesse variabili globali (all'interno del package) e quindi agli stessi valori. La soluzione di cui sopra è invece appropriata per variabili statiche (ossia condivise all'interno di ogni classe).

Un metodo di classe o di oggetto riceve sempre in automatico un primo argomento che specifica la classe o l'istanza.

Questa cosa non dovrebbe stupire particolarmente, poiché è già quello che avviene nei normali compilatori ad oggetti: il primo parametro di un metodo di istanza è il puntatore/riferimento all'istanza stessa. E' in questo modo che i compilatori predispongono la variabile this. In altre parole, il metodo Java seguente:

viene mutato dal compilatore silenziosamente nel seguente:public class MyClass{

public void instanceMethod(String arg1, int arg2){

this.stringVariable = arg1;

this.integerVariable = arg2;

}

}

public class MyClass{

public void instanceMethod(MyClass this, String arg1, int arg2){

this.stringVariable = arg1;

this.integerVariable = arg2;

}

}

Da notare che il primo parametro, di nome simbolico this, è un riferimento all'oggetto stesso. In altre parole i metodi di istanza ottengon come parametro la zona di memoria (o meglio il riferimento a tale zona) dove risiede l'oggetto sul quale si agisce. Perl segue lo stesso percorso: il primo argomento di un metodo di istanza contiene il riferimento all'oggetto stesso, di modo che il metodo possa essere scritto come:

La differenza è che qui è compito del programmatore ricordarsi che il primo argomento è il riferimento all'istanza; il compilatore Perl infatti fa solo la prima parte del lavoro (passare al metodo il riferimento come primo argomento).sub instanceMethod{

my ($this, $arg1, $arg2) = @_;

...

}

Quanto sopra per quello che riguarda gli oggetti, ma per le classi?

In un linguaggio OOP come Java/C++ i metodi di classe (es. static) non necessitano di nessun argomento particolare o di modifiche da parte del compilatore. Infatti quello che avviene è che viene tenuta in memoria la tabella di dispatching dei metodi e l'invocazione di un metodo corrisponde al salto all'indirizzo fornito da questa tabella. Ma il metodo non ha bisogno di sapere se appartiene ad una classe oppure no, come non ha bisogno di sapere a che classe appartiene poiché per forza di cose, se non è di istanza, deve essere di classe.

In Perl questo non è vero: essendo una classe implementata tramite un package, i metodi all'interno del package potrebbero essere di istanza, oppure di classe, oppure nessuno dei due (normali metodi globali). Perl allora fornisce un modo per informare un metodo che è stato invocato in un contesto di classe (ossia come se fosse un metodo di classe): questo metodo riceverà infatti come primo argomento il nome (stringa) della classe/package al quale appartiene.

Riassumendo quindi, tutti i metodi di classe o di oggetto in Perl ricevono come primo argomento una variabile che indica il nome della classe (metodo di classe) o il riferimento all'oggetto stesso (metodo di oggetto) e non ricevono nulla se sono chiamati in un normale contesto di package.

In Perl non esiste il concetto di costruttore (e di distruttore).

Siccome Perl non fornisce nessuna parole chiave per definire una classe, i metodi costruttori (e distruttori) non esistono. Questo non significa che non si possano creare dei metodi appositi per l'inizializzazione delle variabili di un oggetto. Tali metodi dovranno ovviamente restituire al chiamante il riferimento alla struttura dati dell'oggetto.

Un metodo usato come costruttore non deve avere lo stesso nome della classe.

Siccome questi metodi non sono dei veri e propri costruttori, non devono seguire le regole standard dei costruttori Java e C++: essi possono (o meglio devono) avere un tipo di ritorno (solitamente il riferimento alla struttura dati dell'oggetto) e possono avere un nome non vincolante (solitamente new).

In Perl non esiste l'operatore new.

Quando si incontra qualcosa che assomiglia all'operatore new per l'allocazione di un oggetto, si sta in effetti osservando la chiamata di un metodo di nome new (si veda il punto precedente).

Il compilatore passa automaticamente ad un metodo il primo argomento (nome della classe o riferimento ai dati) quando si usa l'operatore freccia.

Quando la chiamata ad un metodo avviene attraverso l'operatore freccia, il compilatore passa come primo argomento del metodo l'oggetto lvalue su cui viene applicato l'operatore freccia. In altre parole:

LVALUE->method(arg1, arg2, arg3);

corrisponde a:

Questo significa quindi che usando l'operatore freccia su i metodi di un package si ha automaticamente una chiamata a metodo di classe, mentre usando l'operatore freccia su dei riferimenti ad oggetti si ha una chiamata ad un metodo di istanza. Quindi ad esempio, per creare un nuovo oggetto, si può invocare il metodo new nei due modi equivalenti:method(LVALUE, arg1, arg2, arg3);

$objectReference = Person->new('Luca', 'Ferrari'); # sintassi di classe

$objectReference = new( Person, 'Luca', 'Ferrari'); # sintassi di package

e analogamente, una invocazione di metodo di oggetto può essere scritta come:

Perl deve sapere quali riferimenti puntano ad un oggetto e quali no.$objectReference->setName('Giovanni'); # sintassi di oggetto

Person::setName( $objectReference, 'Giovanni'); # sintassi di package

Il costruttore di un oggetto non deve solo inizializzare l'oggetto e il suo stato, ma deve anche informare Perl che il riferimento non è un normale riferimento ma un collegamento ad un oggetto. Questo avviene tramite l'operatore bless, che accetta il riferimento ad una struttura dati e la classe/package a cui la struttura dati appartiene. L'operatore memorizza in una tabella il collegamento fra il riferimento e il nome del package/classe a cui è associato, in modo da poter individuare a quale classe il riferimento appartiene. In particolare, in seguito al blessing, l'operatore ref applicato ad un riferimento di oggetto restituisce il nome della classe per la quale è stato fatto il blessing.

Sulla base di questa considerazione, il template generale per un costruttore di oggetto è il seguente:

sub new

{

my ($class, @args) = @_;

# inizializza i valori dell'oggetto

$this = { arg1 => $args[0],

arg2 => $args[1],

...

};

bless( $this, $class );

return $this;

}

Sulla base di tutti i punti di cui sopra, è possibile paragonare la creazione di una classe/oggetto fra un linguaggio OOP (es. Java) e Perl. Supponiamo di avere la seguente classe Java:

public class Person{

public static int personCounter = 0;

private String nome = null;

private String cognome = null;

public Person(String nome, String cognome){

this.nome = nome;

this.cognome = cognome;

Person.personCounter++;

}

public String getNome(){

return this.nome;

}

public String getCognome(){

return this.cognome;

}

}

e di volerla tradurre in Perl. La sua definizione diviene la seguente:

che può essere testato con il seguente main:#!/usr/bin/perl

package Person;

# variabile statica (la stessa

# condivisa fra tutte le istanze)

$personCounter = 0;

sub new

{

my ($class, $name, $surname) = @_;

# creazione nuovo riferimento ad hash

# con i dati (stato) dell'oggetto

$this = { name => $name,

surname => $surname,

};

# associo il riferimento alla classe

bless( $this, $class );

# incremento il contatore di istanze create

$personCounter++;

print "\nCreazione di un nuovo oggetto di tipo $class (numero $personCounter)\n";

# restituisco il riferimento appena creato

return $this;

}

sub getNome

{

my ($this) = @_;

# restituisco il dato richiesto

return $this->{name};

}

sub getCognome

{

my ($this) = @_;

# restituisco il dato richiesto

return $this->{surname};

}

package main;

$person1 = Person->new('Luca','Ferrari');

$person2 = Person->new('Paperon','De Paperoni');

print "\nPersona con nome ", $person1->getNome();

print "\nAltra persona con nome ", $person2->getNome(), " ", $person2->getCognome();

print "\n\n";

che produce il seguente output:

Creazione di un nuovo oggetto di tipo Person (numero 1)Altra persona con nome Paperon De Paperoni

Creazione di un nuovo oggetto di tipo Person (numero 2)

Persona con nome Luca

Ereditarietà e Polimorfismo

L'ereditarietà in Perl viene implementata in modo molto semplice: è disponibile un array globale all'interno dello spazio dei nomi di un package, denominato ISA, che contiene le classi/package dalle quali si vuole ereditare. L'idea quindi è semplice: ogni package definisce una lista di ulteriori package in cui cercare dati e/o metodi. Quando Perl non trova un attributo nel package specificato inizia ad esplorare (sequenzialmente) l'array ISA al fine di trovare in ogni classe specificata il simbolo, e quindi lo utilizza.

Per meglio comprendere questo concetto, si consideri di estendere la classe Person con una classe Male che implementa una persona di sesso maschile:

package Male;

@ISA=(Person);

sub new

{

my ($class, $name, $surname) = @_;

# creazione nuovo riferimento ad hash

# con i dati (stato) dell'oggetto

$this = { name => $name,

surname => $surname,

};

# associo il riferimento alla classe

bless( $this, $class );

# incremento il contatore di istanze create

$personCounter++;

print "\nCreazione di un nuovo oggetto di tipo $class (numero $personCounter)\n";

# restituisco il riferimento appena creato

return $this;

}

Come si può notare la definizione del costruttore è praticamente la stessa della classe Person, addirittura si referenzia un simbolo ($personCounter) che qui non è stato ancora definito. Ora se un programma crea un nuovo oggetto di tipo Male:

$maschio = Male->new( $person1->getNome(), $person1->getCognome() );

print "\nPersona maschio con nome ", $maschio->getNome(), " ", $maschio->getCognome();

l'output di esecuzione è del tutto simile a quello del programma precedente, e addirittura la variabile $personCounter inizia il suo conteggio come fosse separata dalla classe Person (ovvero come fosse stata definita singolarmente di classe). Tutta la magia viene fatta nella ricerca dei simboli, che anziché passare per una vtable passa per l'array ISA del package corrente (ogni package può ridefinire il proprio @ISA).

La ridefinizione dei metodi è automatica, quindi se si ridefinisce il seguente metodo nella classe Male si ha che la chiamata a getNome() verrà risolta da tale metodo:

E' inoltre possibile riferirsi alle proprietà della classe base mediante l'uso di SUPER. Si presti attenzione poiché qui super è un operatore che si preoccupa di salire di un livello nella scala dei riferimenti, ma il nome della classe deve essere sempre specificato come primo argomento: SUPER deve quindi essere usato in combinazione con l'operatore freccia.package Male;

@ISA=(Person);

sub new

{

my ($class, $name, $surname) = @_;

# creazione nuovo riferimento ad hash

# con i dati (stato) dell'oggetto

$this = { name => $name,

surname => $surname,

};

# associo il riferimento alla classe

bless( $this, $class );

# incremento il contatore di istanze create

$personCounter++;

print "\nCreazione di un nuovo oggetto di tipo $class (numero $personCounter)\n";

# restituisco il riferimento appena creato

return $this;

}

sub getNome

{

my ($this) = @_;

return $this->{name} ." (maschio) ";

}

package Male;

@ISA=(Person);

sub new

{

my ($class, $name, $surname) = @_;

$this->SUPER::new( $name, $surname );

# associo il riferimento alla classe

bless( $this, $class );

# incremento il contatore di istanze create

$personCounter++;

print "\nCreazione di un nuovo oggetto di tipo $class (numero $personCounter)\n";

# restituisco il riferimento appena creato

return $this;

}

sub getNome

{

my ($this) = @_;

return $this->SUPER::getNome() ." (maschio) ";

}

Si noti che quando si usa SUPER la parte a destra viene sempre invocata con la sintassi di package (::) mentre quella di sinistra con la sintassi ad oggetto (->).

Per concludere